2023年11月22日、Stability AIがたった1枚の画像から動画を生成できる Stable Video Diffusion を公開しました。

https://ja.stability.ai/blog/stable-video-diffusion

https://stability.ai/news/stable-video-diffusion-open-ai-video-model

今回は、このStable Video Diffusion WebUI(SVD-webui)をローカルにインストールする方法を解説します。

0.事前にインストールするもの

配布元(Github)では、必要なものとして以下の2つが記載されています。

まだ、これらのインストールをしていない場合は、以下の記事を参考にインストールしてください。

1.SVD-webuiをローカルに複製

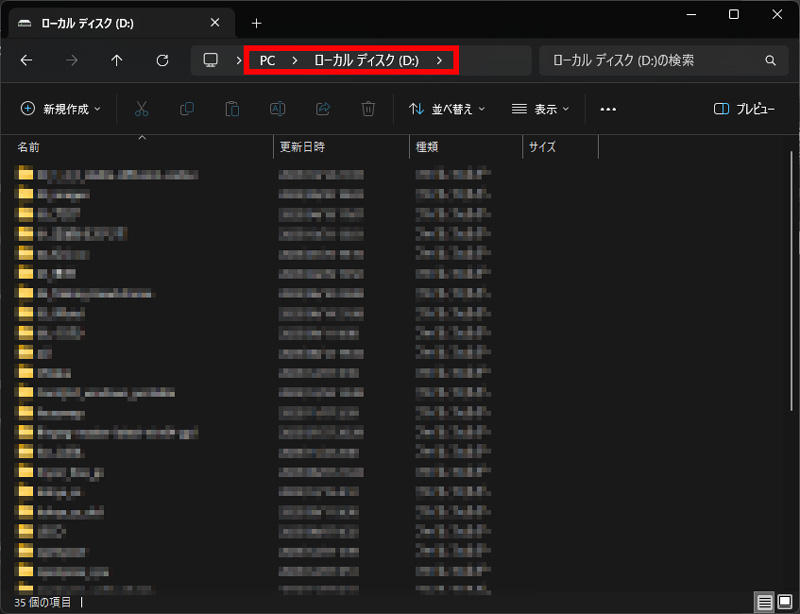

(1)エクスプローラーでインストールする場所を開く

ここでは、Dドライブの直下にSVD-webuiをインストールします。

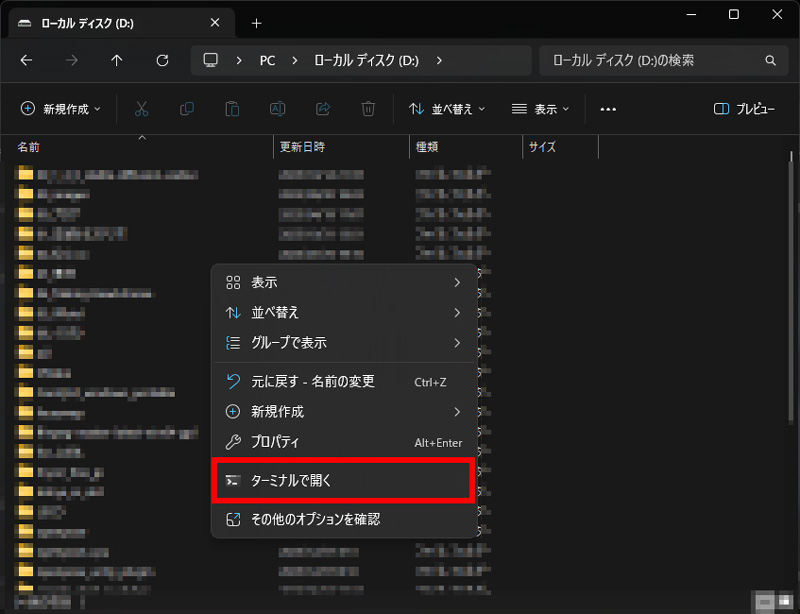

(2)エクスプローラー上で右クリックし、「ターミナルで開く」を選択

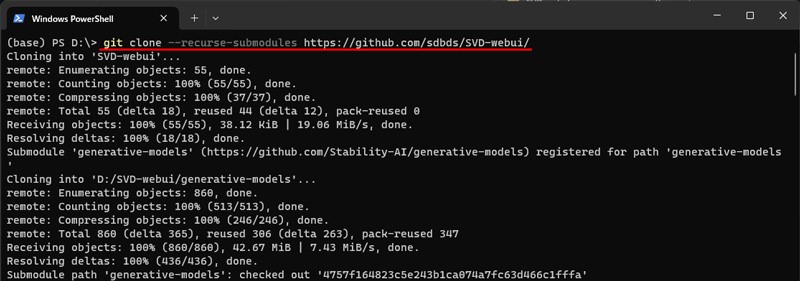

(3)Githubから SVD-webui を複製

以下のコードをコピーしてターミナルに貼り付け、Enterキーを押下

git clone --recurse-submodules https://github.com/sdbds/SVD-webui/

数秒~数十秒で複製が完了します。

Dドライブに SVD-webui フォルダが作成され、必要なファイル複製されます。

2. SVD-webui インストール

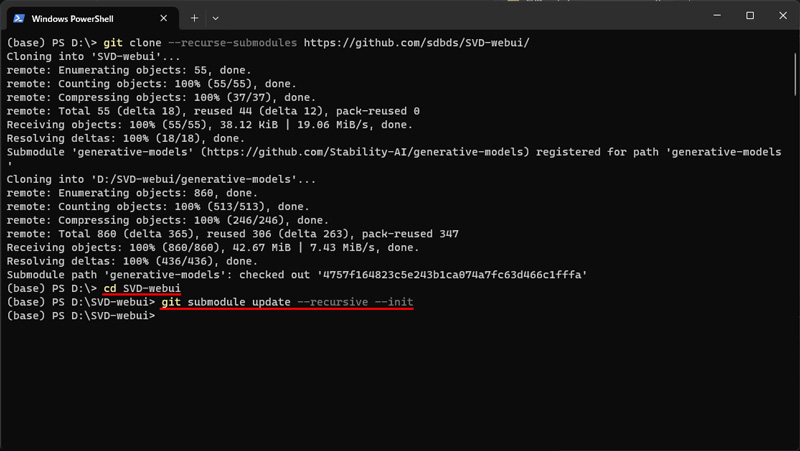

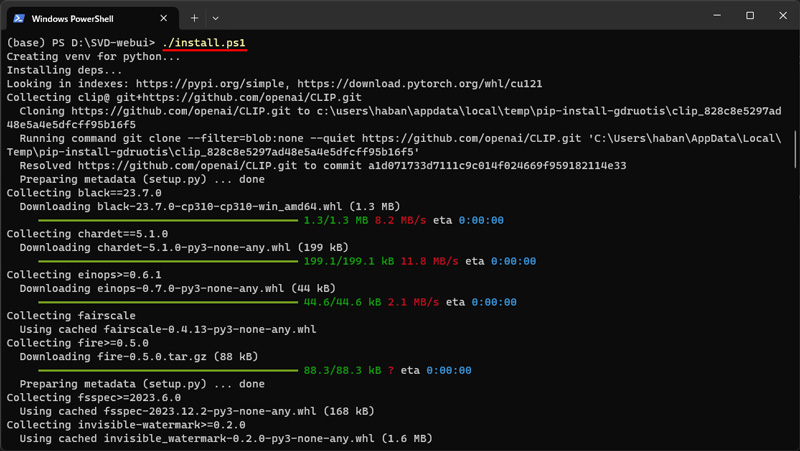

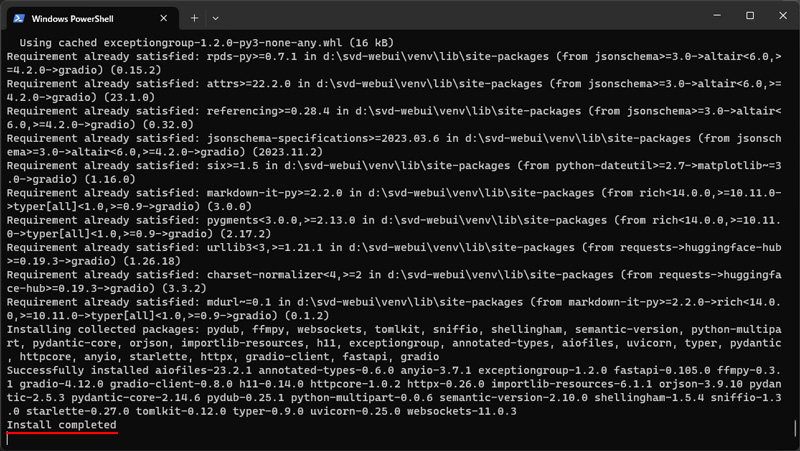

(1)開いているターミナルで以下のコマンドを実行

cd SVD-webuigit submodule update --recursive --init

./install.ps1

Install completed と表示されたらインストール完了です。

3. SVD-webui 用モデルのダウンロード

SVD用のモデルは、Hugging FaceのStability AIページでダウンロードできます。

VRAMの容量を確認してダウンロードしてください。

svd.safetensors(約9GB):14フレーム生成用モデル(15GBのVRAMが必要)

svd_xt.safetensors(約9GB):25フレーム生成用モデル(18GBのVRAMが必要)

ダウンロードしたモデルは、SVD-webuiフォルダ内のcheckpointsフォルダに配置します。

\SVD-webui\checkpoints

RTX4060Ti(VRA16GB)でも25フレーム生成用モデルが使用できましたが、生成速度はグッと下がります。決して、お勧めはしません。

下の動画は、25フレーム用モデルで生成した動画です。

4. SVD-webui の起動

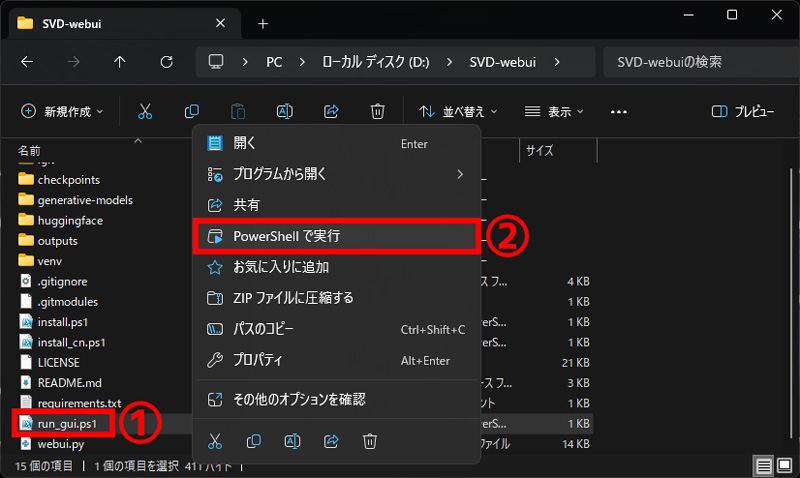

(1)マウス操作で起動

- SVD-webuiをインストールしたフォルダを開く

- run_gui.ps1 を右クリック

- コンテキストメニューの「PowerShellで実行」をクリック

(2)ターミナル(PowerShell)から起動

- ターミナル(PowerShell)を開く

- SVD-webuiフォルダに移動

ターミナル(PowerShellのコマンド例): cd d:\SVD-webui - run_gui.ps1を実行

ターミナル(PowerShellのコマンド): ./run_gui.ps1

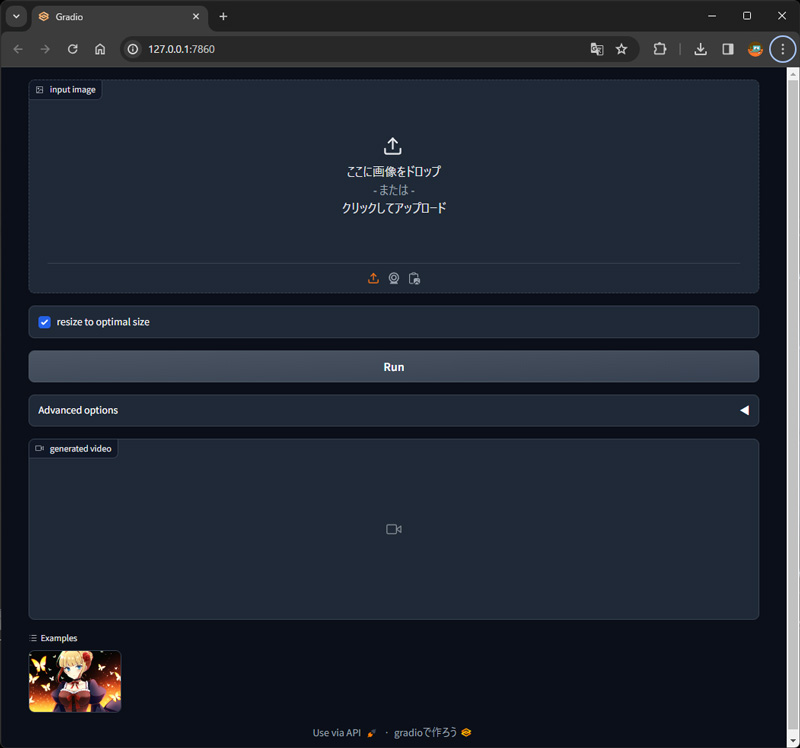

これでSVD-webuiが起動します。

画面左下には、サンプル画像のオマケ付きです。

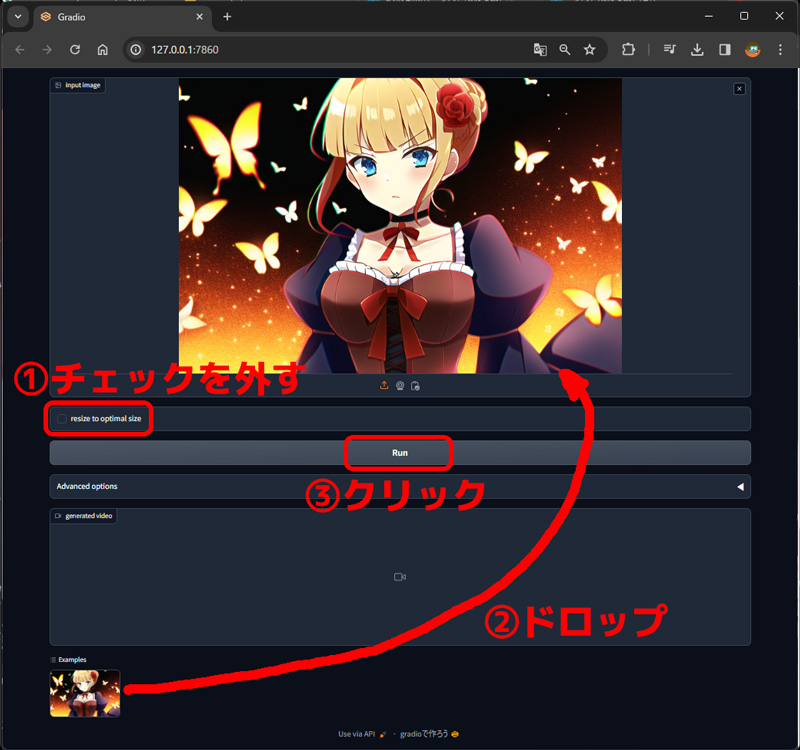

5. SVD-webui の使い方

使い方は、非常にシンプルです。

「ここに画像をドロップ-または-クリックしてアップロード」に画像をドロップして、Runボタンをクリックするだけです。

Runボタンの上の resize to optional size のチェックを外してからRunボタンを押しましょう。

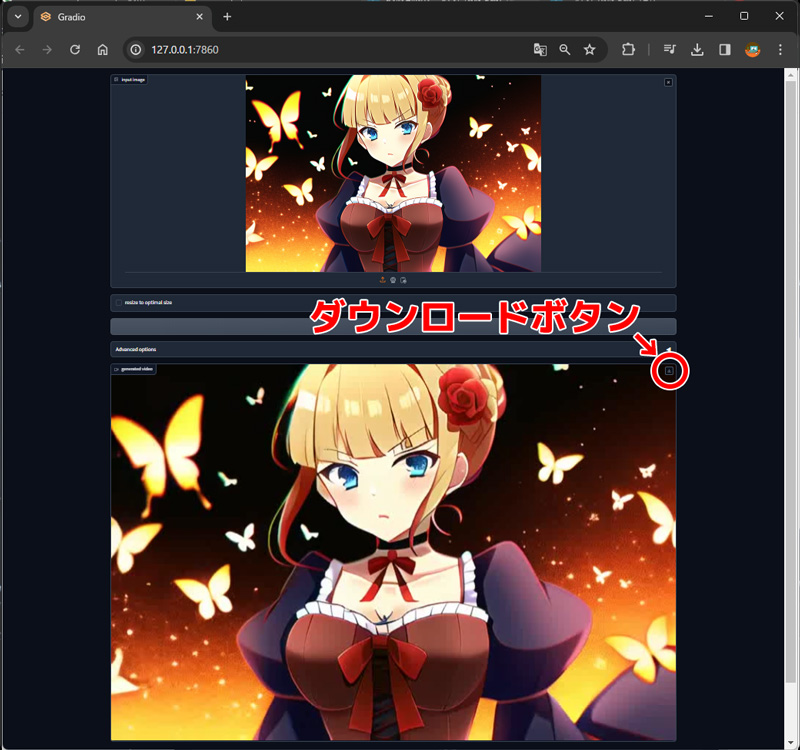

生成された動画は、\SVD-webui\outpts に自動保存されます。

生成された動画の右上のダウンロードボタンでも保存できます。

これだけではつまらないので、もう少し触ってみましょう。

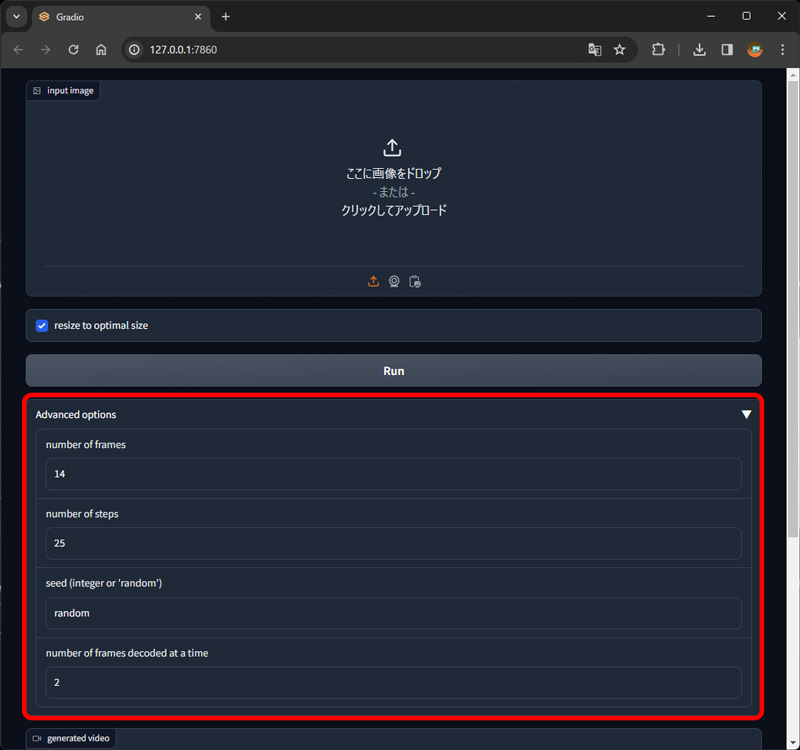

(1)Advanced options

触るといっても、変更できる項目は4つのみです。

number of frames

動画の長さをフレーム数で指定します。

| モデル | デフォルト値 |

|---|---|

| svd.safetensors | |

| svd_xt.safetensors |

number of steps

動画を生成する際のステップ数を指定します。

倍にしたり半分にしたり、色々な数値で試してみましたが、大きな違いは分かりませんでした。

| モデル | デフォルト値 |

|---|---|

| svd.safetensors | |

| svd_xt.safetensors |

Seed

整数 か ramdom を入力します。

それっぽい整数を入れてみましたが、randomと全く同じ動画が生成されました。

使い方が間違っているかも。。。

number of frames decoded at a time

一度に処理するフレーム数を指定します。

デフォルト値2のままで使用した方が良いと思います。

3を超えるとグラボが悲鳴をあげます。

(2)モデルの切り替え

モデルの切り替えは、インストールフォルダの直下にある run_gui.ps1 をメモ帳などで編集します。

run_gui.ps1 の1行目に記述されているモデルのファイル名を書き換えて上書き保存すればOKです。

$model_path="./checkpoints/svd.safetensors" ←14フレーム生成用モデルの場合

$outputs="./outputs"

$port=7860$model_path="./checkpoints/svd_xt.safetensors" ←25フレーム生成用モデルの場合

$outputs="./outputs"

$port=7860

コメント